云服务厂商以及数据中心供应商正在以一种前所未有的速度打造AI系统,对于他们来说消费级AI用例的增加,驱使AI加速器成了新时代下最重要的硬件基础设施资源之一。但在打造这些系统之时,他们也在斟酌不同方案的选取。

英伟达的专有AI生态

作为目前不折不扣的AI芯片王者,可以说英伟达提供了一套完整的AI基础设施方案,基础算力以GPU为核心,辅以Arm CPU,结合专有的CUDA软件生态,加上Infiniband网络和NVLink的互联方案。对于客户而言,他们完全可以直接选择英伟达的打包方案,就能直接开始构建高性能AI应用。

计算层面上,GPU依然是目前最万用的AI算力硬件,英伟达在架构上的创新显著提高了新一代Blackwell GPU的算力,尤其是在生成式AI应用上。结合大容量的HBM,无论是计算还是带宽,都是目前AI硬件的领头羊。云服务厂商和不少构建大型AI应用的公司,仍在大量购置英伟达GPU或基于该硬件生态的服务器。

同样不可忽视的还有CUDA这一护城河生态,即便作为封闭的专有软件栈生态,CUDA依然凭借庞大的开发者社区和应用站在了顶点。比起芯片设计的技术优势,这一生态才是绝大多数AI芯片厂商难以企及的优势。

博通的开放之路

但也有的厂商凭借别的路线实现了成功,比如博通提供的“开放”标准。在大多数人看来,博通是一家网络与通信巨头,为客户提供开放的以太网连接方案、PCIe互联方案以及共封装光学方案等。然而事实上,博通也有营收相当可观的定制芯片设计业务。通过给云服务厂商提供芯片设计服务,这些客户得以推出基于自研计算架构的AI加速计算芯片,同时具备较快的迭代速度。

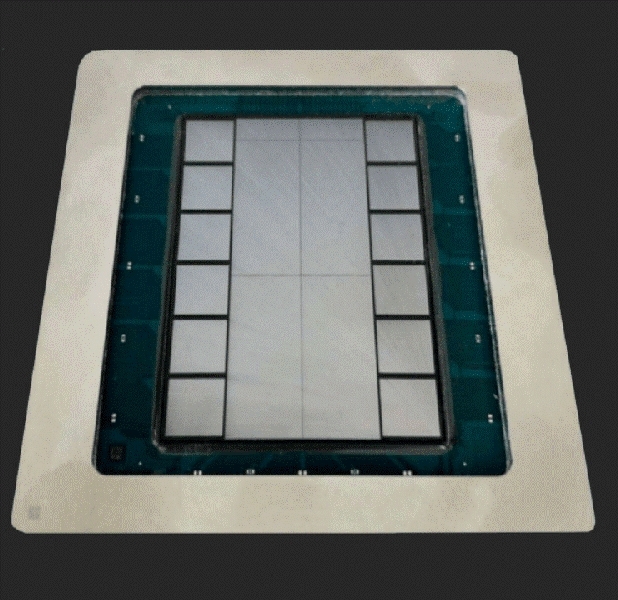

博通在不久前举办的AI投资者大会上展示了他们参与设计的新款XPU芯片,从图中可以看出,除了中间两个大大的计算单元外,左右两边都是HBM内存,一共有12块,这已经到了目前台积电CoWoS-S封装的极限,容量可能超过英伟达的Blackwell,由此可以看出,使用该芯片的厂商追求极高的AI性能,很有可能是微软、Meta之类的大型云服务厂商。

据预测,2024博通半导体业务中,来自AI的营收将达到35%,其中不仅包含两大客户的定制ASIC方案量产,也包含新的第三大客户今年相关产品量产。需求推动之下,AI芯片的营收目标将达到100亿美元。

不难猜出,其中一大客户就是谷歌,他们与博通联合打造的XPU就是已经发展至第五代的TPU芯片。至于新加入的客户,据透露其第三个XPU设计来自另一家大型消费级AI公司。之所以这些客户会选择与博通合作设计XPU,除了博通拥有的丰富AI IP/封装技术外,也离不开极短的开发周期。从设计开发到量产,最短只要10个月的时间。

写在最后

无论是英伟达的GPU路线,还是博通的XPU路线,都为市场提供了更多的选择。而且对于大型云服务厂商而言,他们会同时走这两条路线,为客户提供不同的服务器实例,而自己除了云服务之外的业务上,未来会更加依赖自研的XPU路线。